Andare a vivere su Marte, sperando che sul pianeta rosso la cifra per l'affitto di un monolocale non sia marziana come quella del semicentro milanese: se volessimo riassumere con una provocazione il concetto di lungotermismo, potremmo dire così. Stiamo parlando di una corrente filosofica, è vero, quindi semplificare troppo potrebbe voler dire renderla ancora più incomprensibile o, ancora peggio, un discorso inaugurale vuoto e astruso in stile ministro Giuli. È importante fare una premessa: il lungotermismo non è un pensiero filosofico qualsiasi, ma è il preferito dai miliardari della Silicon Valley e dai colossi Big Tech. Questo lo rende automaticamente pericoloso e, al tempo stesso, indicativo su ciò che potrà succedere nel prossimo futuro. Si tratta di una filosofia che nasce come conseguenza all'Antropocene, ovvero l'era geologica alla quale apparteniamo, in cui il destino del pianeta è la diretta conseguenza delle attività umane, e non più naturali. Il genere umano ha un impatto sulla terra, e pensare in termini di lungotermismo vuol dire tenere conto delle conseguenze a lungo termine, da cui il nome della teoria, di ciò che facciamo.

Teoricamente, il lungotermismo nasce da un'altra forma di pensiero sociale: l'altruismo efficace o effective altruism, che per dirla in maniera basica è l'idea per cui, in un mondo iperconnesso e globale come quello contemporaneo, le responsabilità e le preoccupazioni di ciascuno devono essere condivise a livello di tutto il pianeta, e non secondo una logica di vicinanza o prossimità. Un esempio: se un terremoto colpisce la Nuova Zelanda, dovremmo essere tenuti a preoccuparci ed aiutare come se la catastrofe fosse avvenuta nel nostro Paese, e ovviamente viceversa. Certo, il dispiacere non basta, e tradotto in euro questo vuol dire mettere un cappello logico, e non solo, visto che di soldi si tratta, sul mondo della beneficenza, della filantropia e delle raccolte fondi. Il lungotermismo è un'evoluzione di questo pensiero: se l'altruismo efficace si occupava di gestire la questione in termini di spazio, i lungotermisti hanno a che fare con la dimensione temporale. L'umanità rispetto al pianeta terra è un fatto relativamente giovane, e se non fa le scelte giuste passerà una vecchiaia di merda. Il filosofo William MacAskill, teorico del lungotermismo, ha descritto l'essere umano proprio come un “adolescente imprudente” che vive alla giornata, senza pensieri né idee sul futuro. Ma quali sono i pericoli maggiori che il lungotermismo vorrebbe scongiurare?

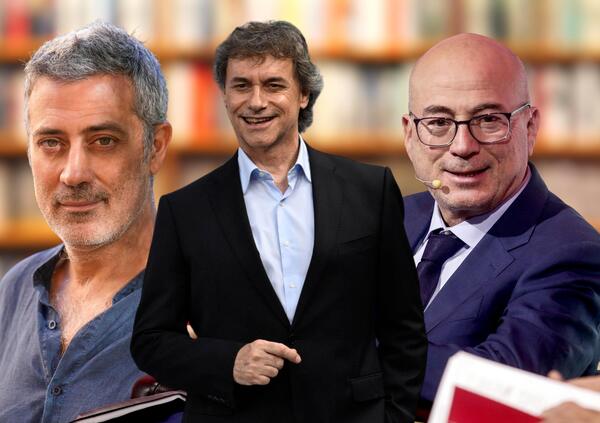

Qui bisogna stare molto attenti, perché il confine tra la previsione e la paranoia distopica è sempre molto sottile, e a separare il pensiero ci sono di mezzo le due principali prospettive sugli umani: buoni o cattivi? Tra i drammatici proclami dei profeti di sventura e le ottimistiche fesserie sulla bontà umana, la cosa migliore da fare è quella di cercare un equilibrio tale da non pensare che i robot di Elon Musk smettano di assemblare le Tesla e si mettano ad assaltare Capitol Hill con dei copricapi assurdi. Certo fa strano sapere che i più preoccupati per la rivolta dei robot siano gli stessi che sono diventati miliardari con la tecnologia, tanto che alcuni di loro, Bill Gates e Sam Altman per dirne un paio, hanno firmato una lettera che parla di “mitigare il rischio di estinzione causato dall'intelligenza artificiale, dalla pandemia e dalla guerra nucleare”, e che questa dovrebbe essere una priorità globale. Come riportato da Milena Gabanelli e Francesco Tortora, un altro megamiliardario tech come Elon Musk risulta finanziatore attivo di un paio di fondazioni lungotermiste. Come ha dichiarato Federico Faggin, scienziato della Silicon Valley, a Gabanelli, il fine del lungotermismo “è preservare il potere di un gruppo di miliardari che controllano lo sviluppo tecnologico, e distogliere l’attenzione dai veri problemi dell’umanità. L’idea di trascurare i nostri simili oggi in nome di un presunto benessere futuro è paurosamente egoista”. Una sorta di greenwashing all'ennesima potenza: si dà l'impressione di voler lasciare un futuro migliore mentre si sta rovinando il presente. Non di tutti, certo, ma questo a un lungotermista non importa. Il problema è tutto qui, e spiega anche perché ai supermiliardari piaccia così tanto questa corrente di pensiero. Se si deve scegliere tra salvare degli sfollati o dei poveri oggi e tra finanziare la ricerca sull'intelligenza artificiale per fare in modo che in futuro non si ribelli contro l'uomo, o progettare viaggi su Marte per colonizzarlo, il lungotermista opta per la seconda soluzione. Ed ecco perché i miliardari spesso si lanciano, come Bill Gates, in scenari distopici pieni di sciagure: i rischi per il futuro esistono, ma vanno considerati come rischi di mercato.